Maskinlæring

Mye av det som kalles kunstig intelligens er i praksis maskinlæring, som er en måte å utforme algoritmer på hvor du ikke tar stilling til hvordan algoritmen ser ut, men kun til resultatet. Ordet har fått en nesten like mystisk klang som kunstig intelligens, fordi vi vanligvis bruker ordet læring om å tilegne oss en dyp forståelse av tema. Her betyr læring noe langt enklere.

Cassie Kozyrkov, som jobber med kunstig intelligens i Google, forklarer det slik at maskinlæring bruker mønstre i data til å sette merkelapper på ting. Enkelt og greit.

En vanlig form for maskinlæring er dyplæring, deep learning, som gjør bruk av nevrale nettverk, en tilnærming som er inspirert av men ikke ekvivalent med menneskelige nevroner. Ordet “dyp” i denne sammenhengen viser til at det nevrale nettverket består av mange lag, og bør ikke leses som “dyp forståelse”.

I starten oppfører nettverket seg mer eller mindre tilfeldig, men vi er i stand til å vurdere om resultatet er riktig eller feil. Hver gang dette fører til et feil svar på spørsmålet man stiller, “straffer” man algoritmen slik at den gir færre slike resultater i fremtiden. Riktige resultater “belønnes”, slik at vurderingene som førte til resultatet videreføres.

For et bildegjenkjenningssystem betyr dette at vi mater systemet med millioner av bilder som vi allerede vet hva er. Bilde 1 er en katt, bilde 2 er en annen katt, bilde 3 er en hund, og så videre. Vi ønsker oss en algoritme som gjenkjenner katter. Derfor viser vi den alle bildene og spør om bildet er katt eller ikke katt. Så forteller vi algoritmen om svaret var riktig, slik at den kan justere seg selv. Etter å ha gjort dette veldig mange ganger, sitter vi igjen med et system som kan kjenne igjen katter.

Det vil si, systemet vil først og fremst kjenne igjen de kattene det har blitt trent opp til å kjenne igjen. Systemet er med andre ord ikke bedre enn datagrunnlaget sitt, noe som blant annet innebærer at eventuelle fordommer eller feilaktige forutsetninger som er bygget inn i datagrunnlaget vil bli videreført i systemet, slik for eksempel rasistiske og absurde personkarakteristikker inngår i det viktige datasettet ImageNet.

Et anet eksempel på tvilsom maskinlæring er den som lå bak den berømte påstanden om at 47% av dagens jobber kan automatiseres. For å komme fram til dette tallet, tok en gruppe eksperter i 2012 stilling til automatiseringsmulighetene i 70 yrker de kjente godt til. Så brukte de dette som treningsdata for en algoritme og matet den 600 andre yrker. Det er denne algoritmen som kom fram til 47%, uten altså å ha noen dypere forståelse av hva yrkene gikk ut. Påstanden gjenspeiler med andre ord en grov forenkling av hva en liten gruppe eksperter tok stilling til for ti år siden, og har lite verdi.

Generative adverserial networks

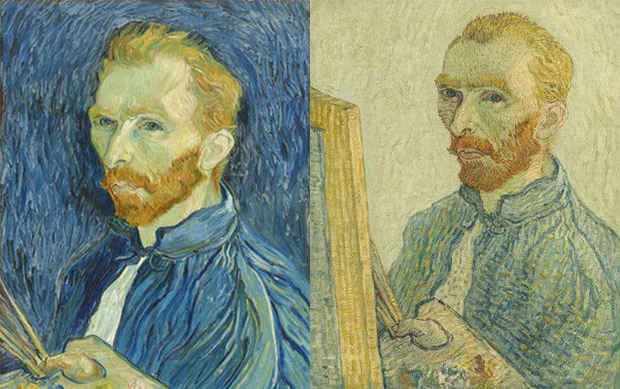

Noen av de mest imponerende maskinlæringsalgoritmene er de som brukes til å skape bilder og video som ser ekte ut. Du kan se slike bilder på This Person Does Not Exist, hvor du får opp et bilde av et tilfeldig generert ansikt hver gang du refresher siden. En tilsvarende metode brukes til å skape falske videoer basert på bilder av ekte mennesker, deep fakes. Slike algoritmer har tilsynelatende et kreativt og analytisk element i seg som man kan være fristet til å kalle kunstig intelligens.

Likevel er ikke disse algoritmene så forskjellige fra algoritmene som kjenner igjen katter i eksemplet over. En av metodene de gjør bruk av er Generative adverserial networks (GAN), hvor du setter opp to algoritmer, en som på forhånd er trent opp til å måle resultatet vi ønsker oss, og en som bruker tilbakemeldingene fra den andre algoritmen til å skape noe som oppfyller dette kravet.

Tenk på det som at du først skaper en algoritme som kjenner igjen kunstforfalskninger, og deretter en algoritme som forfalsker kunst. Disse konkurrerer med hverandre helt til resultatet er troverdig.

La oss si at vi tar algoritmen som kjenner igjen katter, og kobler den til en algoritme som i utgangspunktet genererer tilfeldige bilder. Hver gang den genererer et bilde, får den beskjed om i hvilken grad det ligner på en katt. Vurderingene som fører til kattelignende bilder videreføres, og etter å ha gjort dette veldig mange ganger har du en algoritme som er i stand til å “lure” kattegjenkjenningsalgoritmen.

Resultatet er imponerende, men ikke kreativt eller intelligent, og svakhetene som følger av dårlig datagrunnlag er de samme som for andre maskinlæringsystemer. Samtidig er resultatet uforståelig, fordi ingen mennesker forstår innmaten i algoritmene som er skapt på denne måten. Dette bygger opp under myten om kunstig intelligens som en mystisk autoritet vi må frykte, tilbe eller adlyde.

Fra maskinlæring til forståelse

I artikkelen The Seven Deadly Sins of AI Prediction siterer Rodney Brooks Arthur C. Clarkes formulering om at enhver tilstrekkelig avansert teknologi til forveksling ligner magi, og påpeker at det vi ikke forstår, forstår vi heller ikke begrensningene til. Dermed blir det lett å fantasere om det fantastiske eller uhyggelige potensialet i kunstig intelligens og overvurder skaden eller nytten. Vi ser hvor flinke maskinlæringsystemer er på noen få snevre oppgaver, og generaliserer ut fra dette til at da må de også snart bli flinke til beslektete oppgaver. Mennesker som er flinke til å identifisere dyrearter, vet gjerne også en del om disse dyreartene. Den ene formen for kunnskap henger sammen med den andre. Men en slik generalisert kunstig intelligens finnes ikke, og det er uklart om den kommer til å eksistere og hvilke begrensninger den i så fall vil operere under.

Gary Marcus har kritisert selskapene bak maskinlæringssystemer for å overdrive deres evne til å resonnere. Ettersom alt de gjør er å gjenkjenne mønstre, er også deres kreative evner bare en form for omvendt mønstergjenkjenning. Resultatet kan bli imponerende, men hvis du vet hva du skal lete etter, finner du fort store svakheter i algoritmen. Et kjent eksempel er et bildegjenkjenningsprogram som trodde et bilde av et eple var en iPod fordi bildet inneholdt en lapp med teksten “iPod”. Marcus mener at det ikke er mulig å skalere seg bort fra dette problemet, altså ved å bruke enda større nevrale nettverk og enda mer maskinkraft.

Marcus mener at det som mangler i disse systemene er symbolmanipulasjon. Programvare forholder seg normalt til symboler, altså noe som betyr noe annet. Symbolene og relasjonene mellom dem er definert av de som programmerer systemet. Dyplæring har forsøkt å unngå å kode symboler inn i systemet, fordi dette er en omfattende jobb som er vanskelig å generalisere. Dyplæring lar deg håndtere enorme datasett med lite menneskelig oversyn. Symboler krever langsomt og kostbart tankearbeid. Men Marcus mener at hvis man skal bygge for eksempel selvkjørende biler, må man bruke en kombinasjon av symbolmanipulasjon og dyplæring. Dyplæring alene vil alltid være for skjørt til være brukbart.

Denne kritiske tilnærmingen til det som omtales som kunstig intelligens blir stadig vanskeligere å opprettholde, fordi den omvendte mønstergjenkjenningen du finner i bildegeneratorer som DALL-E 2 og tekstgeneratorer som GPT-3 bygger på så store datasett og så mye maskinkraft at resultatet overvelder vår egen mønstergjenkjenningsevne. Resultatet blir noe som tilsvarer en slags optisk illusjon: En forfalskning som er perfekt tilpasset svakhetene i vår egen forståelse.

Språkforskeren Emily M. Bender mener vi lar oss forføre av ordene som brukes til å selge disse tjenestene. Man sier at systemet “læres opp”, til tross for at læringen er mye enklere enn det vi mennesker tenker på som læring. Man ser for seg at systemene befinner seg på en stigende kurve som en dag vil føre til “ekte intelligens”, når mye tyder på at systemene heller har kjørt seg inn i en blindgate. Bender ber folk som lar seg imponere av slike systemer huske på tre ting:

- At en tekst fremstår sammenhengende betyr ikke at den bakenforliggende modellen forstår noe eller er til å stole på

- At ett svar er riktig, betyr ikke at det neste svaret også vil være det

- Når en datamaskin tilsynelatende snakker språket vårt, er det vi som gjør alt arbeidet

I tidsskriftsartikkelen On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? skrive Bender sammen med Timnig Gebru, Angelina McMillan-Major og Shmargaret Shmitchell at dette ikke er et problem som nødvendigvis kan løses ved å trene opp systemene på enda større datasett. Slike Large Language Models, store språkmodeller, er ikke nødvendigvis av bedre kvalitet enn de som bygger på mindre datasett. Blant annet vil et system som mates med enorme mengder tekst fra internett gjenspeile de ulike skjevhetene og fordommene som inngår i produksjonen av nettinnhold, og som gjør at noe innhold er lettere tilgjengelig enn annet. Du ender opp med en pagegøye som etteraper det den har hørt, som i tilfellet internett vil være vektet i retning hvite menn, med en god porsjon rasisme inkludert.

Det er ingen tvil om at resultatet er imponerende, men en papegøye som ikke forstår hva den snakker om vil nødvendigvis ha begrenset verdi.

Selv om maskinlæring ikke er intelligent, er det et effektivt verktøy til å løse bestemte oppgaver, og må ikke forveksles med bullshit-AI, som er en markedsføringsbløff som gjemmer tradisjonelle algoritmer og/eller manuelt menneskelig arbeide på innsiden.

Tilbake til algoritmer, teknologi og start.