Moderering av Facebook

Man bør tenke på moderering i Facebook som noe som foregår i to omganger: Den første og egentlig viktigste handler om hva slags innhold som blir promotert i nyhetsfeeden. Innhold som ikke passer inn i hva anbefalingsalgoritmen er designet for å løfte frem, det vil si innhold som ikke bidrar til økt aktivitet og tidsbruk, blir i praksis nesten usynlig. Det er lov å poste det, men du får lite belønning i form av likes og kommentarer for det, og over tid vil man dermed legge ut mindre av slikt innhold.

Sagt på en annen måte: Ytringsrommet på Facebook er begrenset for de som ikke innordner seg etter nyhetsfeedens prioriteringsregler.

Den andre omgangen med moderering er den hvor man aktivt fjerner innhold og brukere som bryter Facebooks retningslinjer. Denne omgangen er på mange måter mindre viktig, men får mer av oppmerksomheten vår, fordi reaksjonen er så drastisk, og fordi det vekker sterke reaksjoner i oss når vi ser noe som vi mener ikke burde være der.

Mye av denne modereringen utføres i det skjulte av profesjonelle innholdsmoderatorer av typen Sarah T. Roberts intervjuet i boka Behind the Screen. Dette er mennesker som har et detaljert regelsett å forholde seg til, og som sitter dagen lang og ser og leser store mengder til dels ekstremt innhold. Samtidig har de gjerne lite mulighet til å påvirke reglene de håndhever. Disse utformes på et høyere nivå, av mennesker som antagelig har en mindre direkte erfaring med innholdet det gjelder.

I tillegg besitter de ikke nødvendigvis den språklige eller kulturelle forståelsen som skal til for å tolke det de modererer riktig, se for eksempel hva som skjedde da HL-senteret ble utestengt fra Facebook fordi de brukte et QAnon-bilde i invitasjonen til et arrangement om konspirasjonsteorier i USA.

I andre tilfeller har de kanskje forståelsen, men følger regler som er mer strenge eller mindre strenge enn normene i kulturen de modererer for. Dette gjelder særlig for innhold om kropp, sex og kjønn.

En modereringsprosess som tar høyde for alt dette ville forutsatt en massiv oppskalering av ressursene Facebook bruker på dette. Dette ville også medført en implisitt påtakelse av ansvar. Ved å gjøre mer, sier man også at man sikter høyere. Innsatsen ville ikke skjermet dem for kritikk, men utsatt dem for mer detaljert kritikk. Facebook har ingen økonomisk interesse av å ta på seg et slikt ansvar. De har heller ingen interesse av å fremheve innhold som forbedrer kvaliteten på brukeropplevelsen, målt ut fra andre kriterier enn aktivitet.

Modereringen (både den som fremhever og den som skjuler) vil derfor av nødvendighet være dårlig. Det finnes ingen insentiver eller maktstrukturer slik Facebook fungerer i dag som kan føre til god moderering.

Gjennom disse to formene for moderering har Facebook en enorm makt over offentligheten i mange land. Makten ligger til syvende og sist hos Mark Zuckerberg, som har en uvanlig sterk kontroll over selskapet han har grunnlagt.

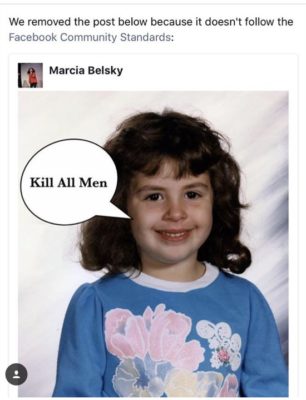

I 2020 innførte Facebook et Oversight Board med ambisjoner om å være en slags uavhengig høyesterett for modereringsavgjørelser. Ideen kom fra jussprofessoren Noah Feldman i 2018, som helt eksplisitt så for seg en høyesterett som kunne henvise til beslutninger fra rettsvesener i ulike land, og som selv en dag kunne bli en slags autoritet ekte rettsaler henviser til. Zuckerberg likte ideen fordi det ville redusere tiden han brukte på å ta stilling til vanskelige modereringsbeslutninger. Rådet ble utformet gjennom workshops hvor grupper fra hele verden tok stilling til ulike modereringsdilemmaer, så som en vitsetegning med teksten “Kill All Men”.

I praksis har Oversight Board blitt noe langt mindre enn en høyesterett. Rådet kan på egen hånd kun ta stilling til enkeltavgjørelser hvor Facebook har valgt å fjerne innhold, og ikke for eksempel avgjørelser hvor Facebook har valgt å ikke fjerne innhold. Det kan heller ikke velge å ta stilling til kategorier med innhold, bare enkeltinnlegg, og heller ikke spørsmål knyttet til politisk reklame eller algoritmer. I disse tilfellene er det Facebook selv som må velge å henvise saken til rådet. Rådets avgjørelser forplikter ikke Facebook til å endre modereringspraksisen sin, slik en tilsvarende høyesterettsdom ville gjort.

Medlemmene av Oversight Board inkluderer blant annet Helle Thorning-Schmidt, tidligere statminister for Socialdemokratiet i Danmark, Alan Rusbridger, tidligere redaktør av The Guardian, og Michael McConnell, en konservativ amerikansk dommer som har kjempet for at speiderbevegelsen skal ha lov til å diskriminere homofile.

En av de første virkelig store spørsmålene rådet har fått på bordet (per februar 2021) er å ta stilling til om den tidligere amerikanske presidenten Donald Trump fortsatt skal være utestengt fra Facebook, etter at han oppfordret en høyreekstrem mobb til å angripe kongressbygningen i Washington i januar. Denne saken måtte henvises til rådet av Facebook selv, noe medlemmene reagerte på. De mente at de selv burde hatt autoritet til å plukke den opp.

Paradokset bak rådet er at Mark Zuckerberg, som hevder å være lei av å bruke tid på slike beslutninger, samtidig har gått langt i å overstyre modereringsavgjørelser i Facebook. I april 2019 sørget han for å endre modereringsreglene i en sak om Infowars-grunnleggeren og konspirasjonsbullshitteren Alex Jones, slik at bare Jones selv ble stengt ute, og ikke også innhold som støttet ham.

Ansatte i Facebook opplevde det som demoraliserende at sjefene kom inn og overstyrte i et spørsmål de hadde lagt så mye innsats i å vurdere. Hva er poenget med retningslinjer når de uten videre kan endres for å komme fram til et annet svar? Dette ser ut til å være en vanlig praksis. Joel Kaplan, som er VP for Global Public Policy, har også spilt en viktig rolle i å overstyre Facebooks håndhevelse av sine egne modereringsregler. Dette har han særlig gjort i tilfeller hvor disse ville rammet høyreekstreme grupper på en politisk sensitiv måte. Kaplans prinsipp har vært “don’t poke the bear”. Ikke gjør noe som terger Trump. I praksis har dermed Facebook en modereringspraksis som er underlagt politiske hensyn. Dermed var det også først etter at Trump hadde gått av som president at Facebook valgte å utestenge ham.

Tilbake til teknologigigantene, teknologi og start.